BTC/HKD+1.57%

BTC/HKD+1.57% ETH/HKD+1.11%

ETH/HKD+1.11% LTC/HKD+2.66%

LTC/HKD+2.66% ADA/HKD+5.65%

ADA/HKD+5.65% SOL/HKD+4.79%

SOL/HKD+4.79% XRP/HKD+7.02%

XRP/HKD+7.02%撰文:TanyaMalhotra

來源:Marktechpost

編譯:DeFi之道

圖片來源:由無界版圖AI工具生成

隨著生成性人工智能在過去幾個月的巨大成功,大型語言模型正在不斷改進。這些模型正在為一些值得注意的經濟和社會轉型做出貢獻。OpenAI開發的ChatGPT是一個自然語言處理模型,允許用戶生成有意義的文本。不僅如此,它還可以回答問題,總結長段落,編寫代碼和電子郵件等。其他語言模型,如Pathways語言模型、Chinchilla等,在模仿人類方面也有很好的表現。

萊特幣創始人Charlie Lee加入BTCS擔任獨立董事:4月5日,萊特幣創始人Charlie Lee加入BTCS擔任新的獨立董事。

注:BTCS是數字資產市場的早期進入者,也是最早專注于數字資產和區塊鏈技術的美國上市公司之一。(雅虎財經)[2021/4/6 19:49:49]

大型語言模型使用強化學習來進行微調。強化學習是一種基于獎勵系統的反饋驅動的機器學習方法。代理通過完成某些任務并觀察這些行動的結果來學習在一個環境中的表現。代理在很好地完成一個任務后會得到積極的反饋,而完成地不好則會有相應的懲罰。像ChatGPT這樣的LLM表現出的卓越性能都要歸功于強化學習。

GrainChain宣布完成820萬美元新一輪融資:專注于農業區塊鏈基礎設施的日本公司GrainChain今天宣布完成820萬美元的新一輪融資,Medici Ventures領投,Eden Block等參投。2018年12月,GrainChain獲Medici Ventures 250萬美元初始融資。在最新一輪融資中,GrainChain的總融資額達到了1070萬美元。GrainChain聯合創始人兼首席執行官Luis Macias表示,這筆資金將使公司能夠“繼續進行產品開發和業務擴張,以滿足更多國家的市場需求”。Macias補充說,公司打算建立一個全球農業市場,將通過區塊鏈技術實現面向生產者透明性和公平性。(SiliconAngle)[2020/3/7]

ChatGPT使用來自人類反饋的強化學習,通過最小化偏差對模型進行微調。但為什么不是監督學習呢?一個基本的強化學習范式由用于訓練模型的標簽組成。但是為什么這些標簽不能直接用于監督學習方法呢?人工智能和機器學習研究員SebastianRaschka在他的推特上分享了一些原因,即為什么強化學習被用于微調而不是監督學習。

Loyens & Loeff成為“Blockchaingers”的合法合作伙伴:由荷蘭連鎖公司(DutchChain)提供動力的“Blockchaingers”是世界上最大的開放式區塊鏈創新項目。此外,它還主辦了2018年的Blockchaingers Hackathon,這是世界上最大的區塊鏈黑客馬拉松的第二版。Blockchaingers是一個封閉型企業,擁有開放的創新項目,旨在加速、放大和連接解決方案、知識和生態系統本身的發展。它通過發展和參與一整年的計劃,來釋放企業、政府、監管機構和初創企業的潛力。目標是建立一個具有凝聚力的行業的聯合創新周期,從挑戰到用例,從原型到實現的區塊鏈解決方案。[2018/3/1]

不使用監督學習的第一個原因是,它只預測等級,不會產生連貫的反應;該模型只是學習給與訓練集相似的反應打上高分,即使它們是不連貫的。另一方面,RLHF則被訓練來估計產生反應的質量,而不僅僅是排名分數。

SebastianRaschka分享了使用監督學習將任務重新表述為一個受限的優化問題的想法。損失函數結合了輸出文本損失和獎勵分數項。這將使生成的響應和排名的質量更高。但這種方法只有在目標正確產生問題-答案對時才能成功。但是累積獎勵對于實現用戶和ChatGPT之間的連貫對話也是必要的,而監督學習無法提供這種獎勵。

不選擇SL的第三個原因是,它使用交叉熵來優化標記級的損失。雖然在文本段落的標記水平上,改變反應中的個別單詞可能對整體損失只有很小的影響,但如果一個單詞被否定,產生連貫性對話的復雜任務可能會完全改變上下文。因此,僅僅依靠SL是不夠的,RLHF對于考慮整個對話的背景和連貫性是必要的。

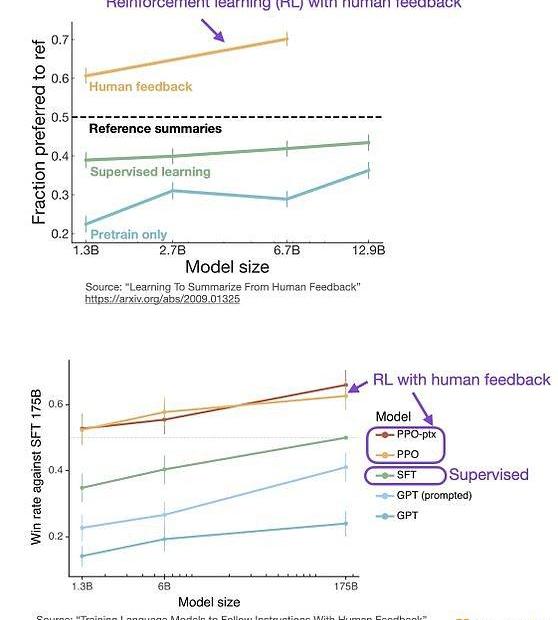

監督學習可以用來訓練一個模型,但根據經驗發現RLHF往往表現得更好。2022年的一篇論文《從人類反饋中學習總結》顯示,RLHF比SL表現得更好。原因是RLHF考慮了連貫性對話的累積獎勵,而SL由于其文本段落級的損失函數而未能很好做到這一點。

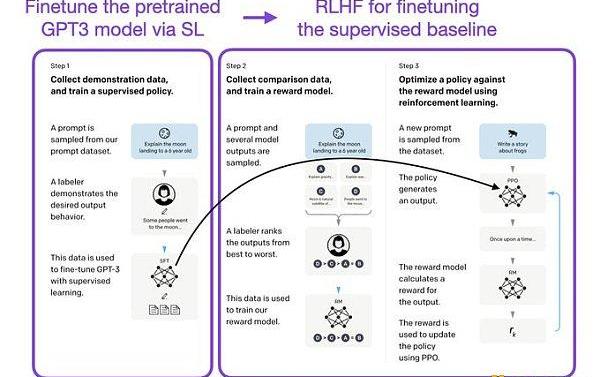

像InstructGPT和ChatGPT這樣的LLMs同時使用監督學習和強化學習。這兩者的結合對于實現最佳性能至關重要。在這些模型中,首先使用SL對模型進行微調,然后使用RL進一步更新。SL階段允許模型學習任務的基本結構和內容,而RLHF階段則完善模型的反應以提高準確性。

金色周刊是金色財經推出的一檔每周區塊鏈行業總結欄目,內容涵蓋一周重點新聞、礦業信息、項目動態、技術進展等行業動態。本文是其中的新聞周刊,帶您一覽本周區塊鏈行業大事.

1900/1/1 0:00:00By:?九九&Zero據慢霧安全團隊情報,2023年3月13日,Ethereum鏈上的借貸項目EulerFinance遭到攻擊,攻擊者獲利約2億美元.

1900/1/1 0:00:00你的身份早已數字化 你其實有一個數字身份,從網絡權限到信息存儲,再到存在瀏覽器中的信用卡記錄,以及你的線上加密錢包中的內容還有存儲在網絡上數百個數據庫中的數據。你的身份是分散的,而且是數字化的.

1900/1/1 0:00:00原文作者:CryptoTrissy原文編譯:aididiaojp.eth,ForesightNews收益率具有跟代幣價格相似的波動性,在牛市中上漲,在熊市中下跌.

1900/1/1 0:00:00原文標題:《WhatisSynthetixV3?》原文作者:MattLosquadro,Synthetix?原文編譯:Kxp.

1900/1/1 0:00:00如果加息25個基點,考慮到近期風險資產價格已納入這種可能,理應沒有太大波動。如果停止加息,風險資產將大幅上漲,btc有望突破3w至3.5w左右,以太坊將破2k至2.5k.

1900/1/1 0:00:00